如果说几年前的人工智能

带来的是令人惊诧的变革和冲击

现在人工智能则正在润物细无声地改变着人们生活

比如你一定在餐厅见过送餐机器人

还有工厂里代替人劳动的机械臂

从梦想照进现实

AI机器人科研人员精益求精

只为向AI更深处探索

让人类生活更加智慧!

但随着科技的更新迭代

AI机器人的研究越来越复杂

某AI机器人实验室就出现了这样的问题

普通服务器面对大量且复杂的AI训练模型

陷入了算力不足的困境

处理时间过长影响科研进度

给科研人员增加很多负担

又或者算力满足了

但算力无法合理分配的问题又来了

实验室算力资源全靠抢

有限的精力不能专注于科研

尤其是进行小规模训练推理时

算力无法切分使剩余算力只能白白浪费

真的没有一款性能强悍的服务器

能给科研人员带来点惊喜么?

答案是:必须有!

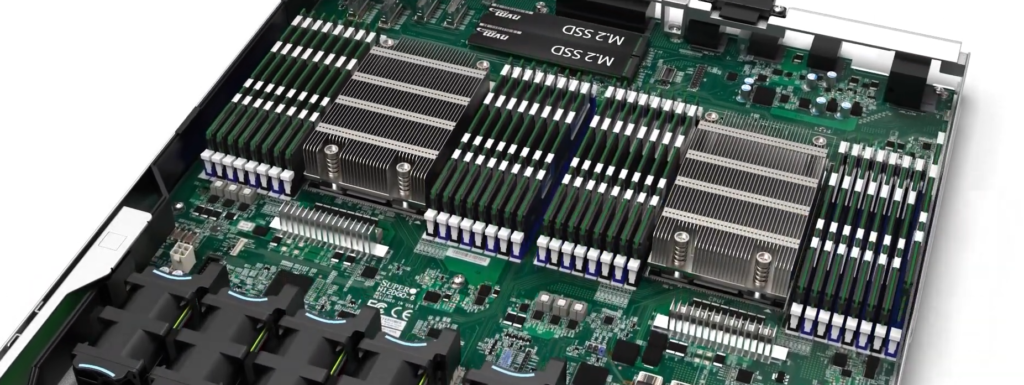

融科联创融威系列

高性能AI计算服务器

RW-4124GO-NART

它的目标 就是要为AI科研铲除障碍!

RW-4124GO-NART惊喜在哪?

咱们一起来捋一捋

全新处理架构专为加速计算而生

针对CPU/GPU异构计算特点,支持双路AMD EPYC™ 7002系列处理器,加速深度学习和HPC应用;支持GPU直连硬盘存储,数据无需经过内存,数据秒读,将延迟降到最低,解决用户在大规模训练数据时,因数据传输慢而增加训练时间的问题。

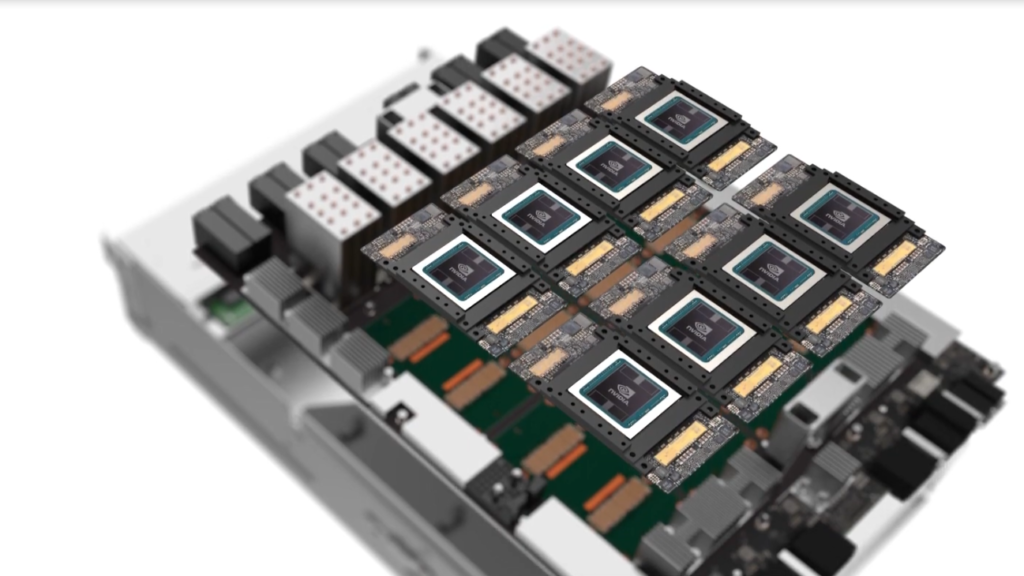

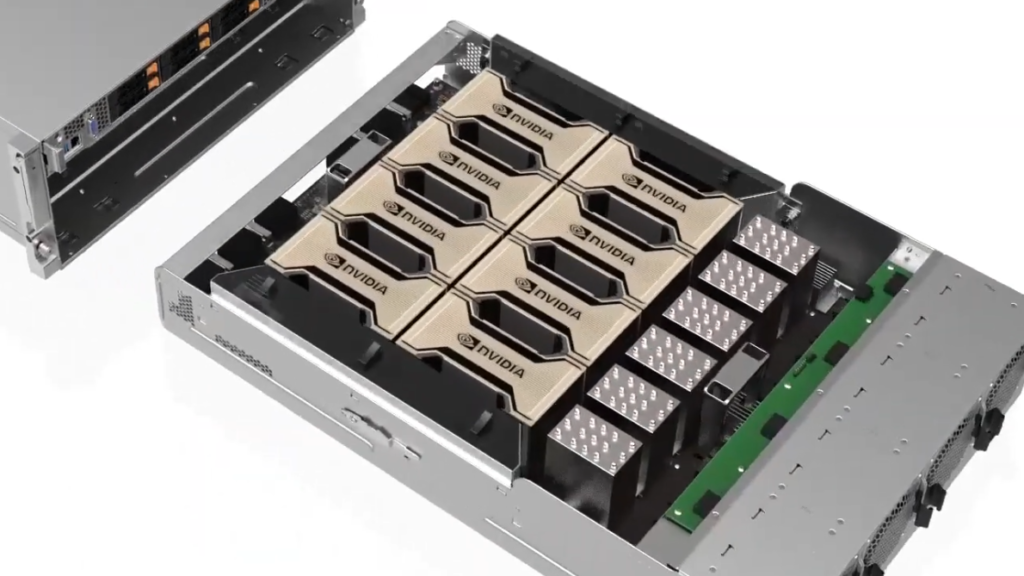

GPU高速互联,NVLINK全力加速

可搭载8片NVIDIA HGX A800 GPU,提供强大算力;独特的NVLINK互联技术,带宽速度比PCIe4.0高出近10倍,在8片InfiniBand适配器和GPU Direct RDMA技术加持下,将原本要花费10小时的双精度模拟过程缩短到4小时之内,多任务处理不卡顿,高效完成训练任务。

GPU合理分配,计算资源高效利用

MIG技术更大限度提高GPU的利用率,从物理上实现GPU切分,最多可同时并行56个执行程序,且互不干扰,解决客户多个训练任务需要排队执行的痛点。可以同时满足训练和推理使用,并且可以让每个独立实例的用户都能使用GPU加速功能,最大限度提高计算资源利用率,减少资源的浪费。

超强扩展能力,完美支撑科研任务

平台集成8通道内存控制器,32个内存插槽,内存容量可扩展至8TB,用户可根据实际需求进行拓展,为AI科研提供超大数据量运算能力。最高支持6个热插拔U.2 NVMe 2.5英寸硬盘,提供良好的稳定性和超强性能,极大提升科研工作效率。

企业级可靠性保证稳定运行

采用超微服务器平台,具备高品质保障,做工精良,3000W(2+2)钛金级冗余电源,4U机架式设计,独特的CPU/GPU独立散热结构,集高性能、高密度与高可靠于一体,确保7×24小时长时间稳定运行,节约成本同时更加绿色节能。

So,AI大咖们还等什么?

如果您遇到难搞的AI机器人科研项目

找融科准没错啦!

RW-4124GO-NART

为您解决AI计算全部问题

再也不怕没资源、算的慢

此款产品适用于所有 AI 工作负载的通用系统

为您的AI科研工作扫清障碍

越来越多的智能机器人

正在让智慧工厂更高速、高精、高效

越来越智能的无人驾驶技术

正在为人类的出行提供便利

还有智能家居

让我们的生活更加舒适

……

人工智能实验室的AI大咖们

正在潜心研究着人工智能这门复杂学科

而我们就是要为大咖们服务

让AI研究更简单

一同探索AI更加精彩的未来!

津公网安备12011402000785号

津公网安备12011402000785号 关注微信公众号

关注微信公众号